COLLECTE ET TRAITEMENT DE DONNEES: des outils toujours plus efficaces

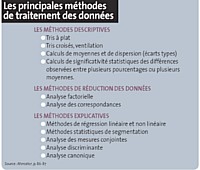

Que seraient les études sans le traitement des données ? Et le traitement sans une bonne collecte ? Selon les professionnels, 40 % à 50 % du coût d'une étude sont consacrés à la collecte de l'information et seulement 10 à 15 % au traitement des données. Or, quelles que soient les techniques d'enquête utilisées, les informations brutes obtenues ne peuvent servir que si elles sont «traitées», rappellent Jacques Lendrevie, Julien Levy et Denis Lindon dans le Mercator

En outre, le traitement des données doit s'adapter au développement des différents modes de collecte et au recours croissant au multimodal dans les questionnaires quanti. Selon Syntec Etudes Marketing & Opinion, 25 % des études quantitatives en France ont été effectuées via Internet en 2008, soit 8 points de mieux qu'en 2007. La technologie apporte aussi de nouveaux outils. A l'instar des études via les pocket PC ou les mobiles. Preuve s'il en fallait une étude de Lightspeed Research

Le traitement des études devient de plus en plus complexe en raison de sources nombreuses et variées, non homogènes. L'outil cross media de Médiamétrie a ainsi nécessité des méthodes statistiques extrêmement sophistiquées. Aux sources études proprement dites viennent s'ajouter d'autres données, notamment issues des mesures passives, du Web 2.0 (blogs, forums, bulletin boards, communautés, sites collaboratifs, micro-blogging, twitt, wiki... ) , sans oublier les banques de données clients. Autant de sources qui peuvent (doivent ?) être intégrées dans un traitement intelligent d'une problématique donnée.

Des outils complets

Cette analyse du buzz a aujourd'hui ses experts ainsi que ses logiciels dédiés (Alceste, AMI Software, SPSS... ). Car «les citoyens s'expriment déplus en plus sur la Toile», constate François Laurent, fondateur de ConsumerInsight, qui souhaite des outils d'analyse permettant à la fois d'appréhender la Toile avec les yeux du surfeur moyen, et de collecter, structurer et analyser scientifiquement les éléments découverts. Pourtant, selon François Laurent, peu d'outils peuvent conjuguer surf intelligent et puissance de traitement. «C'est, bien sûr, la voie royale, mais cela demande des experts capables de maîtriser des approches qualitatives lourdes - c'est-à-dire à la limite du qualitatif traditionnel et de son intuitivité - et du quantitatif, avec son recours au traitement informatique. Un tel profil est rare dans bien des instituts», ajoute-t-il.

Lors du dernier salon Semo, AreYouNet.com, en partenariat avec AT Internet, a présenté une solution pour mesurer la satisfaction client, résultat de la complémentarité de différents types d'outils : les outils de mesure et d'analyse de trafic en ligne d'AT Internet (données comportementales) et les outils de recueil et de reporting en ligne d'AreYouNet.com (données attitudinales) . Quant à Toluna, la société veut, avec son produit BrandSpector, enrichir l'analyse des enquêtes avec des informations issues directement de son panel. « Cela va changer complètement la manière de réaliser et d'analyser les post-tests publicitaires» assure Philippe Guilbert directeur général de Toluna France. Dès cette année la société va d'ailleurs intégrer des informations issues de ses différents sous-panels thématiques.

Par ailleurs, montent en puissance des solutions EFM, concept d' Enterprise Feedback Management, apparu en 2005 aux Etats-Unis, sur lequel des acteurs internationaux comme Confirmit, Globalpark ou Vovici axent leur communication. De quoi s'agit-il ? De la disponibilité, sur une seule plateforme intégrée, de toutes les fonctionnalités nécessaires aux enquêtes, évaluations, tests ou sondages : solutions de ciblage (gestion de panels, échantillonnages...), dispositifs de collecte (enquêtes en ligne, numérisation de questionnaires papier, face-à-face, Internet... ) , outils statistiques puissants (y compris data et text minings) , systèmes de restitution et de reporting adaptés. Intégrée dans le système d'information, cette plateforme est utilisée dans tous les domaines fonctionnels de l'entreprise dès lors qu'il s'agit de collecter et d'analyser de l'information par le biais de questionnaires : études marketing, études de satisfaction, 360°, enquêtes internes, évaluations et expérimentations R&D, contrôle interne...

Pour mesurer le niveau de maturité des entreprises françaises sur ces points et comprendre leurs attentes, Grimmersoft s'est associé à Marketor pour réaliser le premier baromètre de l'EFM en France. Il a ainsi interrogé 22 000 personnes travaillant dans les domaines informatique, marketing/études et RH/ formation. «95 % d'entre elles ont admis ne pas connaître l'EFM, constate Pascal Hébert, président de Grimmersoft. Pourtant, une fois les caractéristiques des solutions EFM présentées, 76 % ont jugé ces outils utiles, voire très utiles. Au final, un quart envisagent défaire évoluer une ou plusieurs applications vers une solution EFM à court terme.»

«Plus que jamais les données sont nombreuses et nécessitent d'être «bien traitées" pour en tirer tout le potentiel décisionnel», souligne Thierry Vallaud, responsable data mining et décisionnel de Socio Logiciels. Il faut faire ressortir les marges d'erreur, les significativités, les biais éventuels. «La généralisation des petits échantillons et des terrains en ligne renforce ce besoin de cohérence des traitements, car des sociétés qui ne sont pas issues des études arrivent sur ce marché», fait-il remarquer. Et d'ajouter : «Bien traiter les données veut dire de l'inférence statistique simple, mais aussi des présentations visuelles «sexy et complétées par des analyses multivariées qui évitent les résultats triviaux et des conclusions non opérationnelles. »

Des traitements de plus en plus complexes...

La complexification des traitements de l'information nécessite un recours plus fréquent à des sociétés spécialisées (Socio Logiciels, Double Précision, Eole, Marketing Studio Services, 5ème Force... ) et ce d'autant plus que tous les instituts d'études ne disposent pas, en interne, des compétences statistiques nécessaires. Récemment, INit et Repères se sont dotés d'expertises internes en statistiques et ont de plus en plus souvent recours aux réseaux Bayésiens. « Cette méthode de traitement de données particulièrement innovante a enrichi nos diagnostics, notamment sur les drivers de l'appréciation globale dans les tests de produit. L'apprentissage non supervisé des relations entre les variables de l'étude permet de découvrir de façon rapide et efficace la structure sous-jacente des perceptions consommateurs. Déplus, la possibilité d'utiliser le modèle pour déterminer le meilleur scénario d'optimisation pour un produit testé nous a fait franchir un cap supplémentaire dans l'opérationnalité de nos diagnostics», constate Fabien Craignou, responsable du département data mining chez Repères, un département créé en 2008.

Le «delivery» joue aujourd'hui un rôle-clé dans la valorisation des données études et du traitement. De lourds investissements ont été consentis par les instituts (BVA, GfK, Ipsos, TNS Sofres, Harris Interactive...) et les sociétés de logiciels pour l'optimiser, notamment grâce à l'utilisation d'Internet. Nombreuses sont les suites logicielles entièrement automatisées, capables de suivre une étude, du terrain au web reporting en passant par le traitement. Aujourd'hui, la grande attente des instituts d'études, qu'ils soient moyens ou petits, est de pouvoir y avoir recours à des prix abordables.

...mais une technologie plus accessible

Parallèlement, les tableaux de bord se font à la fois plus complets et plus faciles à manier. «Nous simplifions la technologie pour que nos clients aillent encore plus loin dans son utilisation», souligne Patrick George, président d'Askia. Ce dernier note que les axes de développement se sont concentrés en 2009 sur la mise à disposition des données en ligne mais aussi la production de rapports automatisés sous forme de fichiers PowerPoint mis à jour directement à partir de l'application de traitement et accessible par le client final. En janvier 2010, la société a présenté son outil d'export PPT à partir des dossiers d'analyse (Vista ou Analyse on-line ou off-line) . Du côté des instituts, Crmmetrix a développé sa propre technologie, EZ-Views. Cette plateforme de reporting permet aux clients et aux consultants d'accéder à des indicateurs-clés, traités automatiquement, en temps réel.

La société d'études Actencia le soulignait lors de sa dernière réunion sur le thème «Evolution des études : crise ou mutation ?» présentée par Brigitte Colas de la Noue, expliquant que la valeur ajoutée des études doit être redéfinie. Chez Socio Logiciels, on pense que le traitement devra devenir plus sophistiqué pour sortir des sentiers battus et donner plus de valeur aux conclusions.

La part du traitement dans un budget études devrait donc croître en valeur. Le traitement devra rajouter de l'expertise. «Au-delà des outils, ce sont bien les hommes, leurs analyses et leurs expertises qui permettent de prendre les bonnes décisions», résume Guillaume Weill, directeur général de Crmmetrix.

@ Marc Bertrand

François Laurent (Consumerlnsight)

«Le développement de l'analyse du discours citoyen nécessite la conjugaison d'outils informatiques dédiés et d'une forte polyvalence intellectuelle des chargés d'études.»

@ Marc Bertrand

Thierry Vallaud (SocioLogiciels)

« en matière de traitement, les clients veulent plus de sophistication, ce petit «plus» qui permettra de faire une recommandation différente, plus «intelligente». »

L'enjeu du traitement pour les études qualitatives

Opinion

Sous l'influence des nouvelles technologies, la collecte et le traitement des données en études qualitatives ont sensiblement évolué. L'avis de georges guelfand, qualitativiste et enseignant à Paris Dauphine.

En collecte, si les anciennes méthodes sont toujours d'actualité (entretiens individuels, en dyades, en triades, en focus group...), les capacités offertes par le Web ont initié une écriture et une culture numérique caractérisées par un volume et une interactivité sans précédent. Manipulation et partage de textes, de vidéos, de photographies, journaux intimes, dessins... toutes ces pratiques nous ont obligés à apprendre de nouveaux langages comme la phonétique, le mélange des codes alphabétiques et alphanumériques, l'usage de smileys... Dès lors, on assiste à la naissance de nombreuses méthodes de recueil permettant aux conso-internautes de laisser libre cours, selon l'expression d'Oriane Deseilligny, à « leur créativité poétique et graphique»

Cette diversification des méthodes de recueil a eu plusieurs effets. Tout d'abord, elle a permis d'atteindre des publics difficilement accessibles.

Ensuite, elle a permis d'accéder efficacement aux expériences non discursives des consommateurs : leurs comportements en situation de consommation. Enfin, elle autorise l'interactivité et une collaboration directe, en situation d'interview, entre client, institut et consommateur.

Ces changements nous ont obligés à repenser nos procédures de traitement. En effet, si les traitements classiques, fondés sur les apports de la psycho-linguistique (analyse thématique, socio-sémantique...) restent utiles, ils deviennent moins opérants lorsqu'il s'agit d'analyser de nouveaux langages, faits d'une floraison de mots et d'images. Il a donc fallu, d'une part, établir de nouvelles procédures de traitement des données et, d'autre part, repenser l'étude qualitative elle-même, la rendre transdisciplinaire et systémique.

De telles évolutions ont eu des conséquences importantes sur la place attribuée à la collecte et au traitement des données. En effet, si le but d'une étude qualitative n'est pas seulement de répondre à des questions, mais aussi de les reformuler, et surtout de mettre à jour les questions pertinentes non encore formulées ; s'il s'agit non seulement d'expliquer la réalité, mais aussi de l'améliorer ; si le but premier est, comme l'indique Jean-Louis Le Moigne

Adopter une telle démarche, qui pense les méthodes qualitatives du point de vue des problématiques à résoudre et des modèles d'interprétation à mobiliser, réclame une exigence nouvelle. Ainsi, les qualitativistes doivent acquérir de nouveaux modes de pensée, posséder une culture qui ne soit pas seulement celle des entreprises et des marchés, mais qui puise aux sources de la littérature, des arts et des sciences... Autrement dit une culture qui se donne les moyens d'analyser les conséquences sur les consommateurs des profondes mutations de nos sociétés

A cette condition, les études qualitatives permettront de lire, de comprendre et d'interpréter les nouveaux langages des consommateurs et de réactiver leur désir de consommer.

Guillaume Weill (Crmmetrix)

«Au-delà des outils, ce sont bien les hommes, leur analyse et leur expertise qui permettent de prendre les bonnes décisions.»

Patrick George (Askia)

«Nous simplifions la technologie pour que nos clients aillent encore plus loin dans l'utilisation de nos outils. »